本地运行 Llama 2 的综合指南

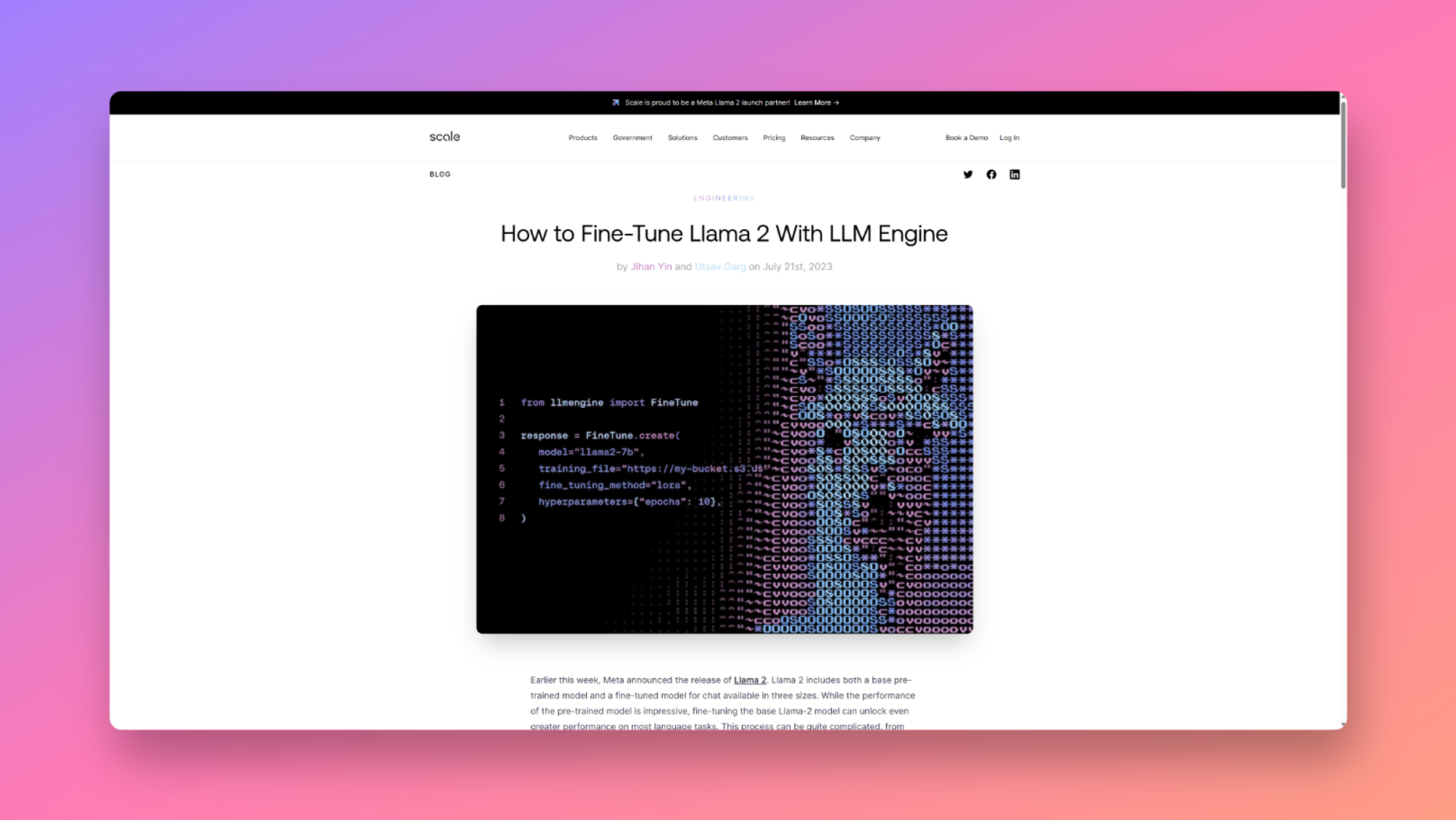

本文介绍了在本地运行Llama 2的方法,包括在M1/M2 Mac、Windows、Linux甚至手机上运行Llama。本文提到了三种开源工具可以用于在自己的设备上运行Llama 2,分别是Llama.cpp、Ollama和MLC LLM。其中,Llama.cpp是一个C/C++的Llama端口,可以在Mac上使用4位整数量化进行本地运行。Ollama是一个开源的macOS应用程序,可以通过命令行界面运行、创建和共享大型语言模型。MLC LLM是一个开源项目,可以在各种设备和平台上本地运行语言模型,包括iOS和Android。

我爱收益

我爱收益